Während sich die Online-Händler über Rekordumsätze freuen, gehen für manchen stationären Laden die Lichter aus. Das veränderte Kaufverhalten der Konsumenten wird Auswirkungen auf Städte, Leben und Kultur haben.

Im Dezember ist Hochkonjunktur bei den Pickern, Packern und Paketfahrern - den geschundenen Arbeitssklaven der schönen neuen E-Commerce-Welt. Dann bringen sie uns, was wir über Kataloge, Tele-Shopping und das Internet bestellt haben, um die Augen unserer Lieben zum Glänzen zu bringen. Die Läden in den Innenstädten dagegen bleiben zunehmend leer. Oh du fröhliche Pappkartonzeit: Zu Weihnachten treffen wir uns nicht mehr in den geschmückten Innenstädten zu Glühwein und Plätzchen, sondern auf den Wertstoffhöfen zum Pappkartonabgeben - damit wir unter diesen nicht in unseren Wohnungen ersticken.

Tote Innenstädte als Folge des zunehmenden Online-Handels?

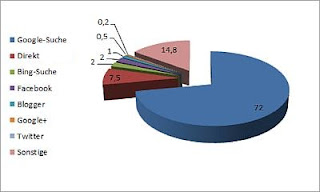

Als ich vor Jahren damit begann, online einzukaufen, dachte ich nicht daran, dass das, was ich nicht nutze - die vielfältigen Einkaufsmöglichkeiten der Innenstädte -, verschwinden könnte. Tat es ja auch nicht, solange wir Online-Käufer nur relativ wenige waren. Wenn uns danach war, dann konnten wir jederzeit in die Innenstädte gehen - die Einkaufsstraßen und ihre Geschäfte waren noch da, genauso wie die Cafés, Kinos und die Museen. Aber dass das noch lange so bleibt, muss man inzwischen bezweifeln.Der Einkauf über das Internet nimmt rasant zu - der Umsatz steigerte sich von 1,3 Milliarden Euro 1999 auf 31 Milliarden Euro 2012. Die Tablet-PCs und Smartphones, die zu diesem Weihnachtsfest verschenkt werden, dürften diese Entwicklung vermutlich noch beschleunigen.

Der Buch- und Musikhandel ist aus den Innenstädten schon fast verschwunden, derzeit tobt ein Kampf um Marktanteile in den Sparten Schuhe und Textilien, den viele stationäre Läden verlieren werden. Die anderen Sparten des Einzelhandels werden wohl nach und nach folgen - die stationären Läden sind zunehmend nicht mehr konkurrenzfähig, denn der Wettbewerb geht zu einem großen Teil über den Preis und die Preise in den Läden der Innenstadt müssen - bedingt u. a. durch die immer höheren Mietpreise an diesen Standorten - anders kalkuliert werden. Dazu kommt, dass die Innenstadtläden nicht nur mit dem Versandhandel (Katalog-, Tele-Shopping- und Online-Handel) konkurrieren müssen, sondern auch mit den Einkaufszentren in den Randzonen der Städte.

Die Geschäfte kämpfen ums Überlegen, die Angestellten um ihre Jobs. Wenn sie verlieren, werden als Folge vermutlich auch der Großteil der Restaurants, Cafés, Kinos und Museen aus den Stadtzentren verschwinden. Die Straßenkünstler werden dann nach Mallorca oder Phuket auswandern müssen oder sonst irgendwohin fahren, wo noch Menschen in einer größeren Anzahl draußen flanieren und sie eine Chance auf Zuschauer und damit Einnahmen haben.

Kundenverhalten ist auch "Kommunikation"

Was Verbraucher tun, ist auch "Kommunikation" in dem Sinne, wie der Begriff im Marketing gebraucht wird. Wenn ich nicht mehr zum Einkaufen in die Läden meiner Stadt oder der nächsten Großstadt gehe, dann signalisiere ich - C2B (Consumer to Business) sozusagen - "Ich brauche euch nicht mehr." Natürlich denkt oder sagt das jeder mal, wenn er oder sie sich gerade über eine schnippische Bedienung geärgert hat. Aber will man deshalb auf die Innenstadt-Shopping- und Kulturinfrastruktur verzichten?Bevor die Innenstädte wirklich sterben, sollten wir als Konsumenten uns dieses Prozesses bewusst werden und uns fragen, ob wir diese Veränderungen, die wir durch unser Verhalten in Gang setzen, wirklich dauerhaft wollen - denn "wenn weg, dann weg".

Innovation um jeden Preis?

Innovation ist (meistens) gut - sie eröffnet neue Möglichkeiten, hat aber auch etwas Destruktives - d. h.: Etwas, was vorher da war, wird von etwas Neuem verdrängt. Der Ökonom behauptet lapidar, der stationäre Handel sei nicht mehr zeitgemäß. Aber stimmt das? Ist er uns nicht mehr wichtig oder sind wir nur vorübergehend neugierig auf die neue Mode "Online-Shopping"?Nicht alles, was verschwindet, ist es wert, dass man es betrauert: Wer vermisst schon Musikkassetten, die sich dauernd zu Bandsalat verhedderten, oder Minipli-Dauerwellen bei Männern, wie es in den 1980er Jahren modern war. Die Frage ist, ob wir für die Innovation "Online-Einkauf" (E-Commerce) unsere lebendigen Innenstädte als Preis aufgeben wollen. Die fehlenden Gewerbesteuereinnahmen aus dem stationären Handel werden die Haushalte der Städte und Gemeinden belasten - d. h., es wird weniger Geld für Kultur-, Architektur- und Infrastruktur-Projekte da sein. Ist es das wert? Oder wie könnte man das kompensieren?

Wenn Online-Kauf zum ethischen Armutszeugnis wird

Es ist eine Sache, wenn man gerne online einkauft, weil es bequem ist und man im Internet eine sehr große Auswahl hat. Viele kaufen auch deshalb online, weil sie hoffen, damit Zeit zu sparen - doch in Wahrheit verbrät man beim Online-Einkauf viel Zeit mit Recherche, auf Postämtern und in Paketshops sowie auf den Wertstoffhöfen, wenn man die enormen Mengen an Verpackungen entsorgen muss.Unethisch wird es jedoch meiner Meinung nach, wenn man sich im Laden ausführlich beraten lässt, dann das empfohlene Produkt aber über einen Online-Händler billiger kauft - dafür gibt es bereits passende Apps. So "kommuniziert" man zwar nicht "Ich brauche euch nicht mehr", aber demonstriert dafür seine fehlende Solidarität (und seine soziale Inkompetenz).

Sollte sich der Trend ausweiten, werden wegen fehlender Einnahmen noch mehr Verkäufer entlassen als ohnehin schon, die restlichen werden mehr und mehr durch billige Auffüllkräfte ersetzt - dann kann man erst richtig über die Inkompetenz von Verkäufern und die Servicewüste im deutschen Einzelhandel meckern. Die Ausbildungsplätze fallen dann auch weg, bis es irgendwann den Gnadenstoß gibt: Insolvenz. Dann kann der Billig-um-jeden-Preis-Konsument seine App wieder löschen.

Sind die Stadtzentren noch zu retten?

Handel und Märkte sind in fast jeder Gesellschaft ein zentrales Element. Sicher - eine Gesellschaft und Kultur sollte sich nicht nur über den Konsum definieren. Und es gibt anderes, das Städte lebendig macht - beispielsweise sind die neuen, manchmal von Kommunen geförderten Urban-Gardening-Projekte neue Orte der Begegnung und Kommunikation - doch wird dieser Trend meiner Ansicht nach nicht die Stadtzentren ersetzen können (und auch nicht die Taschen der Städte und Gemeinden füllen).Wenn die Gewerbesteuereinnahmen des stationären Einzelhandels in den Haushalten der Städte wegbrechen, dann wird das Geld für Restaurierungen fehlen und vermutlich auch viel an gewohnter Innenstadtkultur wegfallen oder teurer werden.

Ich kann am Horizont bis jetzt kein Rettungsschiff erkennen.

Online-Giganten schieben ihre Gewinne am deutschen Fiskus vorbei

Wenn Konsumenten statt in stationären Geschäften vor Ort wenigstens in deutschen Online-Shops einkaufen, haben immerhin deren "Standortgemeinden" was von der eingenommenen Gewerbesteuer. Denn, was ist mit der Steuerpflicht internationaler Großkonzerne wie dem Online-Händler Amazon? Laut taz organisiert Amazon zwar den Versand über Deutschlanddependancen, da die Zahlungen jedoch über die europäische Zentrale in der "Steueroase Luxemburg" abgewickelt werden, dürfte das Geld zum Großteil am deutschen Fiskus vorbeigeleitet werden - letztendlich zu unserer aller Nachteil. Laut Focus handelt es sich im Falle von Deutschland um zweistellige Milliardenbeträge, die dem Fiskus durch Gewinnverlagerungen jährlich verloren gehen - durch amerikanische Unternehmen, die gleichzeitig EU-Subventionen erhalten - mal ehrlich: Die müssen sich doch über uns totlachen! Inzwischen werden einige EU-Länder aktiv, um diesen "Steuertricks" ein Ende zu bereiten. Man wird sehen, ob sie sich durchsetzen können.Innovationen schaffen neue Berufe?

Sicher - im Laufe der Geschichte verschwanden immer wieder Berufe - dafür entstanden neue. Mit dem Internet und dank E-Commerce stieg der Bedarf an Programmieren, Designern, Administratoren, Online-Marketing-Spezialisten etc. Durch seine innovative Kraft, einer perfekten Logistik und mit seinem Image der Zuverlässigkeit hat Amazon entscheidend zum Erfolg und Wachstum des Online-Handels beigetragen - der ja als solcher nichts Schlechtes ist, aber wie alles eben auch Nebenwirkungen bzw. seinen Preis hat. Doch, was wird aus denen, die jetzt Verkäufer sind? Müssen die alle in Zukunft als Picker und Packer bei den Online-Händlern arbeiten oder Paketfahrer bei Logistikunternehmen werden? In beiden Fällen dürften sie beruflich und finanziell demnächst noch weniger zum Lachen haben als jetzt schon, denn diese neuen Jobs gehören zu den prekären Erwerbsverhältnissen: unsicher, sehr schlecht bezahlt, machtlos als Arbeitnehmer und mit wenig Schutz durch Sozial- und Arbeitsrecht. Man kann nur hoffen, dass die Politik endlich gegen die Ausbeutung dieser Menschen vorgeht.Offline- oder Online-Shopping?

Ich würde unsere lebendigen Stadtzentren vermissen - sowohl die großen Konsumtempel als auch die kleinen Boutiquen und Galerien, die Kinos und die kleinen Museen, die Maroni-Verkäufer und die Straßenmusiker. Sie sind doch Teil unserer Kultur. Dabei ist es mir nicht wichtig, ob ich mir jeden Luxus dort leisten kann oder will - ich kann gut damit leben, dass ich es nicht kann. Aber es ist schön, dass sie da sind, dass mich manches dort zum Träumen, anderes zum Kaufen und Schenken anregt.Ich möchte ehrlich gesagt, beides: Online-Handel, wenn es mal schnell gehen muss und ich weiß, was ich will, und den stationären Handel in bunten lebendigen Innenstädten mit Weihnachtsdekoration oder was sonst gerade zur Jahreszeit passt und Verkäufer/Verkäuferinnen, mit denen man mal lachen, aber auch mal streiten kann.

Ich weiß nicht, ob wir beides haben können. Ich werde jedenfalls meinen Beitrag für die Innenstädte leisten, indem ich wieder viel öfter in die Stadt zum ganz altmodischen Einkaufen gehen werde - Retro sozusagen.

Quellen:

- Oh, du fröhliche Paketdienstzeit! (Deutschlandradio Kultur)

- Stationärer Handel nicht mehr zeitgemäß (Tagesspiegel)

- Gigantische Profite, keine Steuern (taz)

- EU-Länder wollen Steuertricks der Internetriesen stoppen (Focus)

- E-Commerce: Alles online, oder was? (Focus)

Um es gleich vorwegzunehmen:

Um es gleich vorwegzunehmen: